人工智能基础软件开发中的数据安全风险与治理路径

在人工智能技术飞速发展的当下,基础软件的开发已成为驱动整个AI产业链的核心引擎。随着其应用的深度与广度不断拓展,与之伴生的数据安全风险也日益凸显,构成了人工智能可持续发展必须面对的关键挑战。对人工智能基础软件开发过程中的数据安全风险进行系统识别,并构建有效的治理体系,已成为当前产业界与监管机构的紧迫议题。

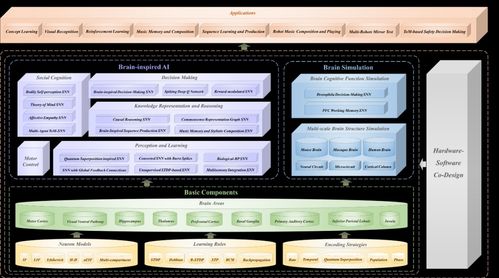

人工智能基础软件开发中的数据安全风险,主要贯穿于数据采集、处理、模型训练及部署应用的全生命周期。在数据采集阶段,海量训练数据的获取可能涉及个人隐私信息的违规收集或过度采集,若数据来源未经充分脱敏或匿名化处理,极易导致敏感信息泄露。在处理与训练阶段,集中化的数据存储与复杂的计算过程面临外部恶意攻击(如数据投毒、模型窃取)和内部管理疏忽的双重威胁,可能破坏数据完整性、损害模型性能,甚至引发系统性安全事件。在部署与应用阶段,基于基础软件构建的AI系统若存在安全漏洞,可能导致模型推断过程中隐私数据被逆向还原,或产生带有偏见、歧视性的输出,对社会公平与伦理规范造成冲击。

针对上述风险,构建多层次、动态化的人工智能数据安全治理框架势在必行。需推动 “安全与隐私设计” 原则前置。在基础软件开发的初始架构阶段,就应嵌入数据加密、差分隐私、联邦学习等隐私增强技术,从源头降低数据暴露风险。应建立健全 全生命周期数据安全管理规范。明确数据采集的合法合规边界,实施数据分类分级保护,并对训练数据质量、模型算法逻辑进行定期审计与透明度评估。强化 技术防御与主动监测能力。开发并部署针对对抗性攻击的检测与防御工具,利用AI技术本身提升异常行为识别和威胁预警的水平。亟待完善 法律法规与标准体系。通过制定专门的人工智能数据安全法规、行业标准及伦理准则,明确开发者的责任义务,并为安全评估、认证及问责提供依据。

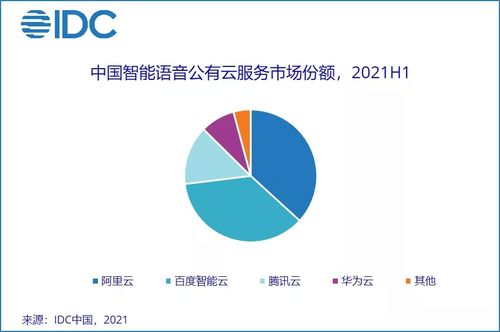

治理实践需多方协同推进。软件开发企业应承担主体责任,将安全视为核心竞争力;学术界需加强安全基础理论与攻防技术研究;监管机构则应创新监管模式,如推广“监管沙盒”,在鼓励创新的同时管控风险。提升公众的数字素养与安全意识也至关重要。

人工智能基础软件开发的数据安全风险治理是一项复杂的系统工程。它不仅是技术问题,更是关乎信任、伦理与法律的社会治理课题。唯有通过技术加固、管理完善、法规健全与多方共治的综合路径,才能筑牢安全根基,护航人工智能基础软件乃至整个产业健康、可信、可持续地发展。

如若转载,请注明出处:http://www.gongxiangdaijia.com/product/59.html

更新时间:2026-03-01 03:39:47